Google ha recentemente introdotto la AI Mode come una nuova esperienza di ricerca avanzata, segnando un cambiamento significativo nel modo in cui gli utenti interagiscono con il motore di ricerca. Annunciata durante Google I/O 2025, la Modalità AI è disponibile come scheda separata in Google Search (attualmente per gli utenti negli USA) ed è stata definita da Google stessa come “il futuro della ricerca”

A differenza di una ricerca tradizionale – con l’elenco di link blu – AI Mode impiega tecnologie di Intelligenza Artificiale generativa per fornire risposte approfondite e conversazionali direttamente nella pagina dei risultati. In pratica, quando l’utente pone una domanda complessa, Google AI Mode fornisce un’unica risposta articolata, capace di anticipare anche le domande successive, invece di restituire solo una lista di siti web.

Questa modalità è stata progettata per gestire interrogazioni più lunghe e articolate: durante i test, le query in AI Mode sono risultate in media due volte più lunghe di quelle classiche e spesso legate a compiti complessi (confronti di prodotti, pianificazioni di viaggi, how-to qui un PDF di approfondimento) AI Mode punta quindi a diventare un assistente di ricerca completo, capace di offrire ragionamenti più avanzati, risultati personalizzati e contenuti multimodali (testo, immagini, grafici) integrati in un’unica esperienza.

Cos’è la Modalità AI di Google Search

AI Mode è una nuova modalità di ricerca che sfrutta modelli di Intelligenza Artificiale generativa (Large Language Models, LLM) per arricchire l’esperienza utente. Invece di fornire solo un elenco di pagine rilevanti, AI Mode elabora risposte complete e contestuali alle domande degli utenti. Questa modalità è accessibile tramite una scheda dedicata (“AI Mode”) sulla pagina di Google – inizialmente attivabile attraverso Search Labs ed ora disponibile a tutti gli utenti negli Stati Uniti senza necessità di opt-in. Quando si effettua una ricerca in AI Mode, Google utilizza un modello AI proprietario (una versione personalizzata del modello Gemini 2.5, il più avanzato modello linguistico di Google) per interpretare la query e generare la risposta. Secondo Google, AI Mode rappresenta la versione di ricerca “più potente” dal punto di vista dell’IA, con capacità di ragionamento migliorate e supporto nativo alla multimodalità (ricerca tramite testo, voce o immagini)

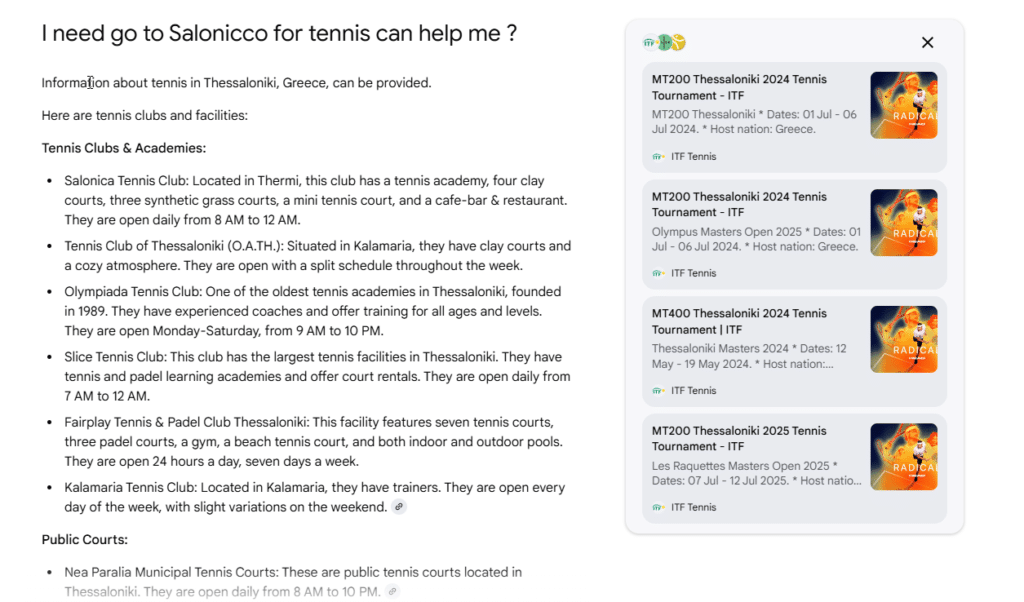

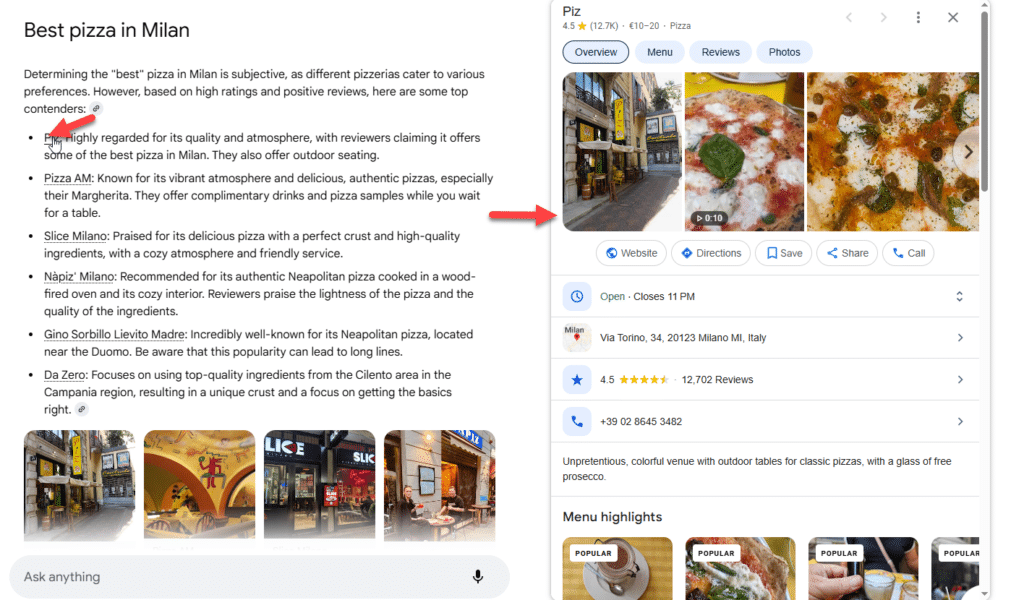

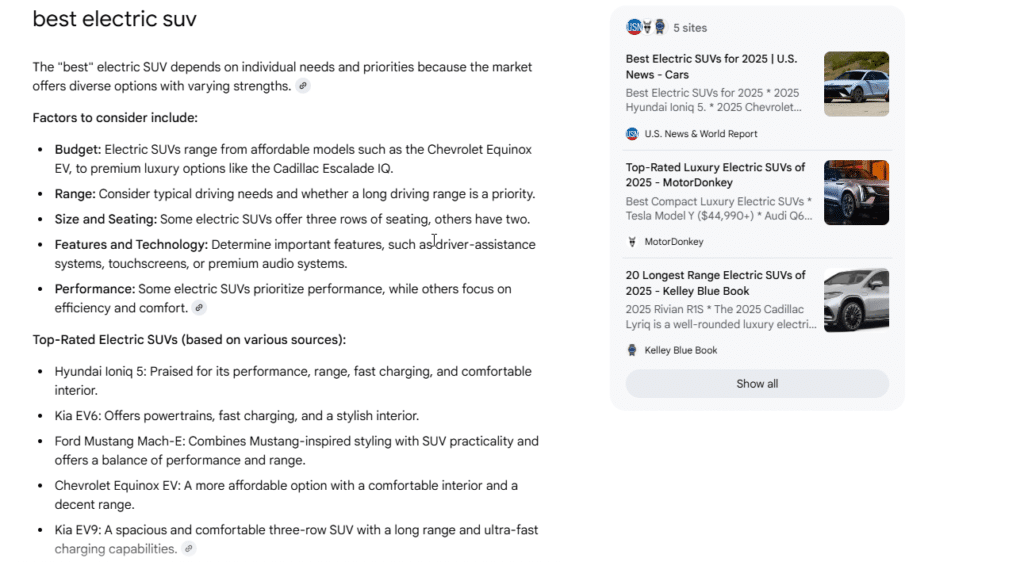

A livello di interfaccia utente, AI Mode si presenta in modo diverso dalla SERP tradizionale: la risposta dell’IA occupa la posizione principale, spesso sotto forma di paragrafo (o elenco puntato) privo di link immediati nel testo. Solo a margine – ad esempio in un pannello laterale sulla destra o in un carosello sotto la risposta – vengono mostrati alcuni link a fonti web esterne utili per approfondire Google sottolinea che AI Mode continua a “mettere in evidenza link utili” a siti di qualità, ma l’approccio è altamente focalizzato sul tenere l’utente all’interno dell’esperienza conversazionale. In effetti, come osservato dagli esperti, AI Mode sembra progettata per trattenere gli utenti nella modalità AI il più a lungo possibile, fornendo molte informazioni direttamente nella risposta e rimandando a risorse interne (es. Google Maps, Google Shopping) quando opportuno

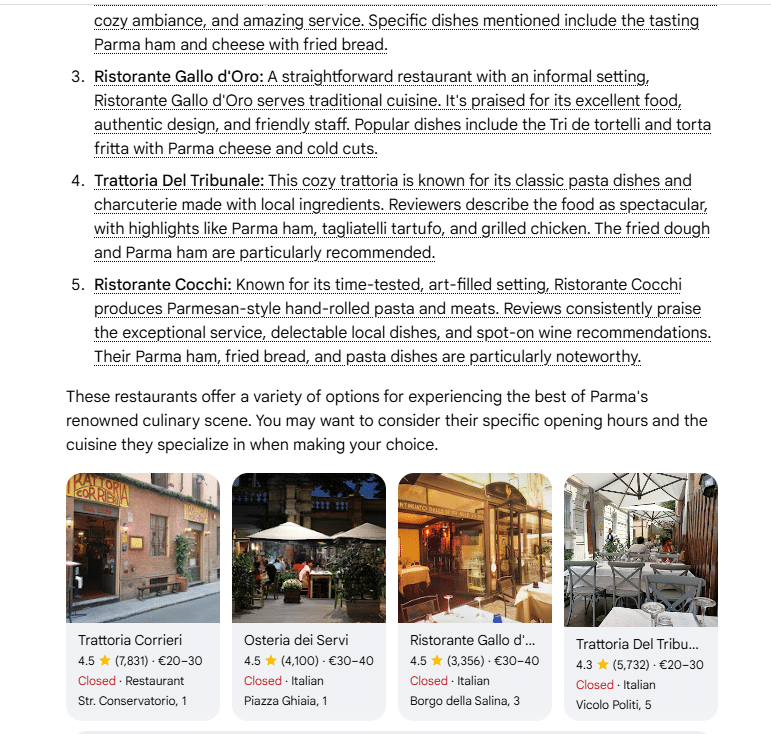

Esempio di risposta di Google Search in Modalità AI – in questo caso per la query “top 5 resturant in Parma”.

L’IA restituisce un elenco approfondito dei migliori ristoranti a Parma, completo di descrizioni dettagliate per ciascuna opzione. Ogni voce include informazioni su stile, piatti consigliati (come torta fritta, prosciutto di Parma e pasta fatta a mano), e punti di forza (atmosfera, servizio, qualità degli ingredienti).A destra, un carosello visuale mostra i profili Google dei ristoranti con recensioni, fascia di prezzo, indirizzo e stato di apertura. Le valutazioni stellari e il numero di recensioni aiutano a orientare la scelta. Ad esempio, Trattoria Corrieri e Ristorante Gallo d’Oro mostrano alte valutazioni e prezzi accessibili, mentre Osteria dei Servi e Ristorante Cocchi sono apprezzati per la raffinatezza e l’autenticità dei piatti locali.

L’icona a forma di link accanto a ciascun nome rappresenta un collegamento interno (“dotted link”) al profilo Google dell’attività, permettendo di esplorare menù, orari e foto senza uscire dall’ecosistema Google.Questo esempio evidenzia come AI Mode offra risposte ricche e contestuali, mantenendo l’utente coinvolto nell’interfaccia di ricerca per un’esperienza informativa fluida e completa.

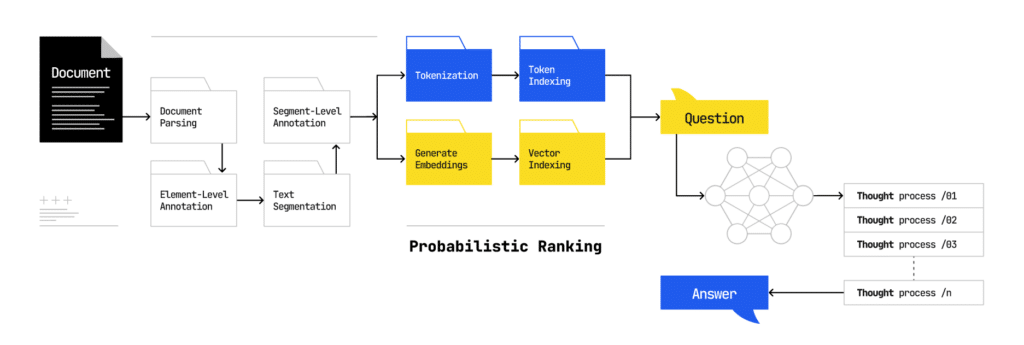

Architettura e funzionamento di AI Mode

Dal punto di vista tecnico, la Modalità AI introduce un’architettura di ricerca stratificata e contestuale, sovrapposta all’indice classico di Google.

A grandi linee (fonte: ipullrank.com), il processo interno di AI Mode può essere descritto come segue:

Comprensione e riscrittura della query: quando l’utente pone una domanda su Google AI Mode, il sistema non la tratta come una singola query isolata. Viene invece applicata la tecnica del “query fan-out”: la domanda iniziale viene silenziosamente scomposta e riformulata in una costellazione di sotto-quesiti correlati. Alcune di queste query derivate sono esplicite (sottotemi ovvi della domanda), altre sono implicite o predittive, volte ad anticipare gli approfondimenti che l’utente potrebbe cercare In pratica, AI Mode espande l’intento di ricerca su molteplici direttrici, scandagliando vari aspetti del tema richiesto.

Ricerca multi-query parallela: tutti i sotto-quesiti generati vengono lanciati simultaneamente attraverso l’infrastruttura di ricerca. In questa fase Google esegue molteplici ricerche in parallelo per recuperare informazioni dal suo indice web, molto oltre la superficie dei classici 10 risultati organici. Nella modalità standard, la ricerca si limita a trovare i risultati più rilevanti per la query singola; in AI Mode, invece, avviene un “tuffo in profondità” nel web: decine (o addirittura centinaia, nella modalità Deep Search) di query vengono emesse per esplorare ogni sfaccettatura del problema e trovare contenuti iper-pertinenti. Google ha descritto questo meccanismo come la chiave per aiutare l’utente a “scoprire ancora più contenuti del web che corrispondono esattamente alla sua domanda

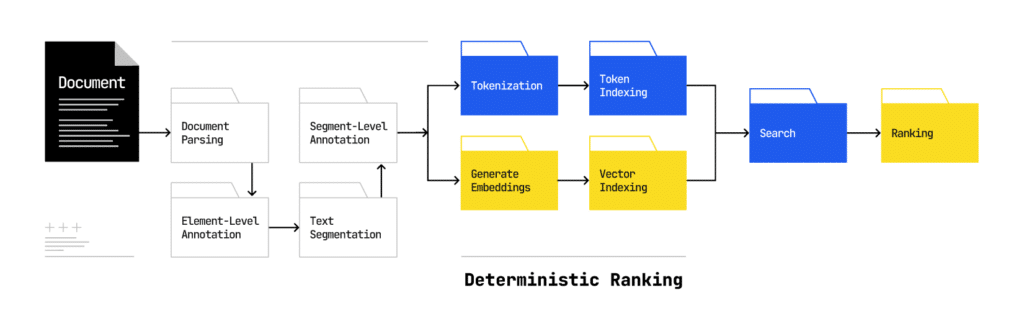

Recupero di contenuti a livello di passaggio: a differenza della ricerca classica orientata alle pagine intere, AI Mode adotta un approccio passage-level. Significa che l’indice di Google e i modelli di recupero lavorano a livello di singoli paragrafi o frasi: ogni documento viene spezzato in “chunk” (segmenti) ed è su questi che avviene l’allineamento con le query. Per ciascuna sotto-query, il sistema estrae dai documenti web passaggi specifici ritenuti rilevanti – ad esempio, una definizione particolare, una statistica, un pezzo di descrizione utile. In backend, Google utilizza dense retrieval, ovvero rappresentazioni vettoriali dense sia delle query che dei passaggi di testo: ogni query e ogni frammento di documento vengono convertiti in un embedding numerico, e la similarità tra questi vettori determina quali passaggi sono considerati pertinenti. Questo approccio consente di andare oltre la corrispondenza esatta di parole chiave, identificando anche contenuti semanticamente affini alla richiesta dell’utente (ad es. sinonimi, concetti correlati). Le tradizionali metriche di ranking basate su parole chiave (TF-IDF, BM25) pur potendo essere impiegate in una prima fase di filtro, non sono più al centro del processo: la pipeline di retrieval di AI Mode si basa prevalentemente su tecniche neurali di ranking vettoriale e similarità semantica

Ranking dinamico con modelli di linguaggio: ottenuto un insieme esteso di passaggi candidati (provenienti da tante fonti differenti), il sistema procede a determinare quali informazioni utilizzare e in che ordine. Qui entra in gioco un meccanismo di ranking “obliquo” mediato da un LLM, molto diverso dal vecchio algoritmo di ranking deterministico. Google ha sviluppato un metodo (descritto in un recente brevetto) in cui il modello linguistico mette a confronto i passaggi a coppie per valutare quale dei due risponda meglio alla query utente. In pratica, al modello viene ripetutamente posta la domanda: “Dato questo quesito, quale tra questi due testi è più rilevante? Attraverso molte comparazioni pairwise tra frammenti, il sistema deriva una graduatoria finale dei passaggi basata sul giudizio del modello. Questo approccio introduce un elemento di ragionamento relativo: non esiste più un punteggio fisso per ogni documento, ma la rilevanza è valutata confrontando direttamente i contenuti l’uno contro l’altro. Il risultato è un ranking probabilistico, mediato dall’IA, anziché deterministico come nei classici algoritmi di Google

Sintesi della risposta in linguaggio naturale: una volta scelti i passaggi migliori, AI Mode passa alla generazione della risposta finale. Va sottolineato che la risposta non è una citazione testuale diretta di un singolo documento, ma una sintesi combinata di informazioni provenienti da più fonti Il sistema opera come un aggregatore intelligente: riordina, parafrasa e collega tra loro i vari contributi informativi per formulare una risposta coerente e completa alla domanda originale. In questa fase entrano in gioco molteplici modelli specializzati (un vero ensemble di IA): ad esempio, un modello ottimizzato per riassumere contenuti, un modello per confrontare dati o opinioni divergenti, un modello per verificare fatti (cross-check) e così via. Ciascuno di questi moduli contribuisce “una battuta” – ossia aggiunge un pezzo di informazione elaborata – e infine un modello di sintesi finale (il regista) assembla il tutto in un testo fluido e naturale. Il prodotto finale è quindi un paragrafo (o elenco) che risponde direttamente alla query dell’utente, spesso anticipando sotto-domande correlate (grazie alla copertura fornita dal fan-out) e fornendo contesto aggiuntivo. Ad esempio, chiedendo “Qual è il miglior SUV elettrico?”, AI Mode potrebbe già includere nella risposta considerazioni sul significato di “migliore” per diversi utenti (autonomia, prezzo, caratteristiche, ecc.) senza che l’utente lo chieda esplicitamente

Presentazione e interazione: la risposta generata viene mostrata in cima alla pagina con un formato conversazionale. L’interfaccia di AI Mode è adattiva e modulare: il layout e gli elementi visuali possono cambiare a seconda del tipo di informazione da presentare. Un LLM downstream nel pipeline è incaricato di decidere come visualizzare al meglio i contenuti – ad esempio sotto forma di testo discorsivo, elenco puntato, tabella comparativa, galleria di immagini o grafico interattivo – in base alla natura della domanda e alle preferenze passate dell’utente. Questo significa che l’aspetto della risposta può variare notevolmente da una query all’altra: per una domanda su statistiche potrebbe apparire un grafico; per un confronto di prodotti, una tabella; per un luogo, magari una mappa integrata. In aggiunta, la risposta include riferimenti alle fonti: in genere piccole icone di citazione o numeri che, se cliccati, aprono la lista delle fonti utilizzate (mostrata in un pannello laterale o in calce). In questa modalità, quindi, l’utente ottiene subito una soluzione “pronta all’uso”, ma ha comunque la possibilità di espandere e verificare su siti esterni tramite i link forniti.

Memoria contestuale e follow-up: AI Mode supporta la conversazione continua. Dopo la prima risposta, l’utente può porre domande di follow-up (cliccando su suggerimenti di approfondimento o formulando nuove domande a mano) e Google manterrà il contesto della sessione. Questo significa che il sistema ricorda ciò che è stato chiesto e risposto in precedenza, per evitare ripetizioni e fornire risposte coerenti nella conversazione. Tecnicamente, AI Mode implementa un “search with stateful chat”, ovvero una chat di ricerca a stato persistente: viene mantenuta una sorta di memoria a lungo termine della sessione, in cui ogni interazione aggiorna il contesto. Questa memoria è realizzata non tanto salvando ogni parola, quanto generando un embedding aggregato della conversazione (una rappresentazione vettoriale del dialogo fin qui) che viene aggiunto come input ai turni successivi. In questo modo, l’IA “sa” di cosa si sta parlando e può interpretare le nuove query in continuità con le precedenti, proprio come farebbe un assistente umano. Ad esempio, se dopo aver chiesto del “miglior SUV elettrico” l’utente chiede “e per una famiglia di 5 persone?”, AI Mode intuirà che ci si riferisce ancora ai SUV elettrici e adatterà la risposta su quel sotto-contesto, senza bisogno di ripetere tutto. Questa persistenza contestuale rende l’esperienza di ricerca più naturale e fluida.

In sintesi, ciò che sembra un singolo risultato generato dall’IA è in realtà il frutto di un’elaborata catena di operazioni: da una query iniziale si passa a decine di query secondarie, centinaia di documenti letti e confrontati, e infine a un testo creato ex novo dall’IA basandosi sui contenuti trovati. Google stessa descrive AI Mode come un “balletto matriciale della cognizione delle macchine” nascosto dietro la semplicità dell’interfaccia. Questa infrastruttura comporta un salto concettuale: non si tratta più di “classificare pagine web” ma di costruire risposte mediante ragionamento automatico su più fonti simultaneamente

Personalizzazione avanzata e risultati dinamici

Uno degli aspetti più innovativi di AI Mode è la forte componente di personalizzazione dei risultati. Google Search da tempo personalizza parzialmente i risultati (ad esempio usando la posizione geografica o l’attività recente quando sei loggato), ma AI Mode porta la personalizzazione a un livello superiore, grazie all’uso di tecniche basate su AI e dati utente approfonditi.

Personal context e user embeddings: Google ha introdotto in AI Mode il concetto di contesto personale (“personal context”). Gli utenti possono – su base volontaria – autorizzare Google a utilizzare dati provenienti dal proprio account Google (come Gmail, Google Calendar, cronologia di ricerca, ecc.) per arricchire le risposte.

Ad esempio, collegando la propria Gmail, AI Mode può leggere informazioni pertinenti (come prenotazioni di voli o hotel) e sfruttarle per fornire risposte personalizzate. Google assicura che questo avviene solo se l’utente effettua l’opt-in e che il collegamento può essere disattivato in qualsiasi momento. I vantaggi però sono notevoli: nell’esempio fornito durante I/O 2025, cercando “cose da fare a Nashville questo weekend con amici, siamo appassionati di cibo e musica”, AI Mode è stato in grado di consigliare ristoranti con posti all’aperto basandosi sulle prenotazioni passate dell’utente e di suggerire eventi in città vicino alla posizione dell’hotel in cui l’utente alloggerà (informazione estratta dalle conferme di volo e albergo trovate in Gmail) In pratica, l’IA ha incrociato i gusti culinari dedotti dalle ricerche passate, la conoscenza delle email di conferma del viaggio e le informazioni di Google Maps per generare una risposta su misura – qualcosa di impensabile per un motore di ricerca tradizionale.

Esempio di risposta personalizzata con dati utente. In questa animazione dimostrativa di Google, AI Mode fornisce suggerimenti personalizzati su ristoranti ed eventi a Nashville incrociando il contesto della query con informazioni personali: email di conferma (voli, hotel) e storico prenotazioni ristoranti. Il risultato è adattato alle preferenze dell’utente (es. locali con musica e posti all’aperto) e alla sua posizione durante il viaggio. La possibilità di collegare Gmail e altre app conferirà ad AI Mode un forte carattere proattivo, avvicinando l’esperienza di ricerca a quella di un assistente personale intelligente.

Tecnicamente, questo livello di personalizzazione è reso possibile attraverso i modelli di embedding utente. Secondo un brevetto recente di Google, il sistema genera per ogni utente un vettore di embedding che rappresenta in forma numerica le sue caratteristiche, preferenze e intenti sulla base dei segnali comportamentali a lungo termine. Questo user embedding funge da “profilo latente” dell’utente: un condensato matematico di tutte le sue ricerche passate, clic effettuati, interessi mostrati, interazioni su vari prodotti Google, ecc. L’embedding viene poi iniettato all’interno del processo di inferenza dell’LLM per modellare le risposte In pratica, ad ogni nuova query dell’utente, il sistema considera non solo la domanda in sé, ma anche questo vettore utente, che influenza tutte le fasi: dall’interpretazione dell’intento (ciò che la query significa davvero per quell’utente specifico) alla scelta di quali sotto-query del fan-out privilegiare, fino al re-ranking dei passaggi in base all’affinità con l’utente e perfino al tono/formato della risposta generata

Questo meccanismo permette di avere un’estrema personalizzazione in tempo reale senza dover ri-addestrare completamente il modello di linguaggio per ogni utente. Il medesimo modello base (Gemini) può servire miliardi di persone, adattando le risposte “al volo” grazie all’embedding utente fornito come contesto aggiuntivo. Inoltre garantisce consistenza trasversale: lo stesso embedding potrebbe essere usato per personalizzare le esperienze su Search, su un assistente come Gemini (es. Bard), su YouTube, su Google Shopping e altri servizi, mantenendo una coerenza di fondo nelle raccomandazioni e nei risultati mostrati a quell’utente. Un esempio eclatante di questo è che un utente ha ricevuto la stessa risposta sia su AI Mode che su Gemini (l’assistente conversazionale), segno che c’è un substrato comune di personalizzazione che guida entrambi

Le implicazioni di questa personalizzazione spinta sono profonde: due utenti diversi che pongono la stessa identica query in AI Mode potrebbero vedere risposte e fonti citate differenti, non per via di differenze nell’algoritmo di ranking, ma proprio perché sono persone diverse. Il motore di ricerca diventa memory-aware, consapevole della “memoria” dell’utente. Ad esempio, se l’utente A in passato ha interagito spesso con contenuti scientifici di alta qualità, e l’utente B no, chiedendo oggi a entrambi “spiegami il cambiamento climatico”, l’AI Mode potrebbe citare fonti più tecniche e dettagliate per A, mentre per B potrebbe mantenere un linguaggio più semplice e fonti più introduttive. L’inclusione di un contenuto nei risultati non dipende più solo dalla pertinenza semantica generale, ma anche dall’allineamento col profilo dell’utente.

Dal punto di vista SEO, questo significa che il classico “posizionamento medio” ha un significato molto relativo in AI Mode: i risultati sono altamente personalizzati e dinamici, per cui monitorare la posizione assoluta di una pagina per una certa query (come se valesse per tutti gli utenti) diventa inefficace. Gli strumenti di rank tracking tradizionali – tipicamente tarati su ricerche generiche in modalità non loggata – rischiano di non cogliere la vera visibilità di un contenuto, perché le risposte possono diventare 1:1 (one-to-one) tra AI e utente. In altre parole, ogni utente ha un suo Google su misura.

Il ruolo dei Large Language Models (LLM) nel nuovo motore di ricerca

Cuore della Modalità AI è l’utilizzo estensivo di Large Language Models all’interno del motore di ricerca. Google ha integrato un modello di linguaggio avanzato – denominato Gemini – direttamente nel funzionamento di Search. In particolare, con il lancio di AI Mode è stata introdotta una versione custom chiamata Gemini 2.5, progettata appositamente per fornire capacità di ragionamento e comprensione multimodale all’interno di Search. Questo LLM è il componente che consente a Google di passare da un semplice matching di parole a una vera comprensione semantica e contestuale delle query e dei documenti.

Le capacità chiave di Gemini (LLM) nel contesto di AI Mode includono:

-

Reasoning avanzato: come descritto, il modello è in grado di spezzettare le domande complesse in sotto-domande e inferire collegamenti logici tra concetti. Questa tecnica, affine al chain-of-thought reasoning, permette a AI Mode di andare oltre la superficie: l’LLM “pensa” a quali informazioni potrebbero servire per soddisfare pienamente la richiesta e guida il sistema nel recuperarle. Inoltre, tramite i confronti pairwise tra passaggi, l’LLM applica un ragionamento comparativo per decidere la rilevanza (es.: “questo paragrafo risponde meglio di quell’altro perché copre anche il caso X”). Questo approccio introduce un elemento di intelligenza “critica” nel ranking: il modello non conta solo occorrenze, ma argomenta su quale contenuto sia più utile.

-

Generazione del linguaggio naturale: Gemini è addestrato per produrre testo coerente e grammaticalmente corretto, simile a quello umano. Quindi può prendere informazioni grezze (una serie di fatti estratti da vari siti) e trasformarle in una risposta ben formulata, con frasi di senso compiuto. Il tono è generalmente neutro e informativo, ma può variare se il contesto lo richiede (ad esempio può spiegare in modo semplice termini complicati se capisce che la query proviene da un utente meno esperto). L’LLM consente anche di parafrasare contenuti di terze parti, evitando copie esatte: se più pagine forniscono lo stesso concetto, AI Mode può sintetizzarlo una volta sola nella propria frase. Questo ha dei risvolti importanti sui copyright e sul fatto che spesso le risposte AI non vengano attribuite al 100% a una singola fonte, perché sono una riformulazione originale basata su molte fonti

-

Multimodalità: Gemini 2.5 è un modello multimodale, il che significa che può elaborare input e produrre output in formati diversi, non solo testo. Ad esempio, AI Mode può accettare immagini come input (tramite Google Lens/”Search Live”) e capirne il contenuto per rispondere a domande visive. Può anche prendere risultati numerici o dataset e generare grafici o tabelle come parte della risposta. L’LLM è in grado di “descrivere ciò che vede” in un’immagine o di estrapolare i dati rilevanti per costruire una visualizzazione. Questo apre la strada a un motore di ricerca molto più ricco: se chiedo “mostrami graficamente le differenze di rendimento tra due investimenti”, AI Mode può direttamente generare un grafico comparativo, invece di elencare link a siti finanziari.

-

Adattabilità e contestualità: grazie ai meccanismi di prompting contestuale, il LLM può plasmare le risposte in base a contesti specifici. Come visto, l’embedding utente è una parte di questo contesto. Ma anche altre cose: per esempio, l’LLM può essere “istruito” a seguire linee guida di qualità e sicurezza (evitando linguaggio inappropriato, risultati non attendibili, ecc.). Google ha infatti posto grande enfasi sulla qualità e sicurezza delle risposte AI, integrando filtri e controlli nell’LLM per ridurre al minimo allucinazioni o errori grossolani. Rispetto alle prime versioni di AI generativo (come gli AI Overviews del 2023, che a volte davano risposte inaccurate o facilmente manipolabili dallo spam), AI Mode con Gemini 2.5 punta a risposte più affidabili e “logiche”, basandosi su catene di ragionamento verificabili. Lily Ray, che ha testato AI Mode, ha notato che le risposte “sembrano più intelligenti e logiche” rispetto alle precedenti AI Overviews, con meno affermazioni sbagliate o incoerenti. Un esempio: i vecchi sistemi AI di Google Search si confondevano persino sull’età di Lily Ray (rispondendo con valori assurdi come 9 anni o 102 anni), mentre AI Mode ha dedotto in modo sensato che tali età non avrebbero avuto senso dato il suo profilo professionale – segno di un certo common sense integrato nel modello.

I Large Language Models come Gemini non sono più confinati a chatbot o prodotti separati, ma diventano parte integrante del motore di ricerca, ridisegnandone l’architettura. Il motore di ricerca classico era basato su indici invertiti e ranking di pagine; il nuovo motore di ricerca include al suo interno componenti neurali che comprendono, sintetizzano e personalizzano le informazioni. Questo significa che fare SEO non è più soltanto ottimizzare per un algoritmo statico, ma anche tenere conto di come un modello di AI potrà interagire col nostro contenuto (leggerlo, capirlo, smontarlo e rimontarlo). Nei prossimi anni, vedremo probabilmente un’integrazione sempre più stretta tra LLM e ricerca, con continui miglioramenti (Google parla di portare le “capacità di frontiera” di Gemini prima in AI Mode e poi gradualmente nel core della Ricerca).

Funzionalità chiave introdotte da AI Mode

Oltre alle differenze architetturali, AI Mode porta con sé una serie di funzionalità innovative che arricchiscono l’esperienza di ricerca. Molte di queste sono state presentate come anteprime durante Google I/O 2025 e verranno sperimentate tramite Search Labs prima di un eventuale rilascio definitivo. Vediamo le principali:

Deep Search: ricerca “profonda” con report dettagliati

Una delle novità più interessanti è la modalità Deep Search, pensata per gli utenti che vogliono il massimo dettaglio e profondità nelle risposte. Attivando la funzione Deep Search in AI Mode (ad esempio tramite un pulsante dedicato nell’interfaccia), Google esegue un fan-out ancora più estremo, arrivando a emettere centinaia di sotto-ricerche per coprire ogni angolo dell’argomento richiesto. Il sistema poi ragiona attraverso informazioni disparate provenienti da molte fonti e le assembla in un vero e proprio rapporto approfondito, completo di citazioni puntuali alle fonti originali. L’idea è quella di far risparmiare all’utente ore di ricerca: invece di leggere decine di articoli e PDF, l’utente ottiene un documento riassuntivo di livello esperto, generato in pochi minuti dall’IA. Google ha affermato che Deep Search può produrre risposte di livello esperto con riferimenti completi, rappresentando quindi uno strumento potentissimo per la ricerca accademica, il giornalismo investigativo, l’analisi di mercato ecc.

Esempio di Deep Search in azione. Questa GIF (Google I/O 2025) mostra AI Mode mentre esegue un Deep Search: la barra di avanzamento indica le centinaia di query lanciate, e al termine viene prodotto un lungo report con più sezioni, ciascuna corredata da riferimenti numerati a fonti web. Deep Search sfrutta la stessa tecnica di query fan-out, ma “portata al livello successivo” secondo Google, risultando in una risposta articolata e riccamente documentata, ideale per chi necessita di uno studio approfondito senza doverlo comporre manualmente.

Live Search: ricerca visiva in tempo reale

Un altro aspetto innovativo è l’integrazione di Google Lens e delle funzionalità di realtà aumentata nella ricerca AI. Con la funzione denominata Live Search, è possibile usare la fotocamera dello smartphone o dispositivi AR per porre domande su ciò che si vede in tempo reale. Ad esempio, puntando la fotocamera su un motore guasto e chiedendo “come riparare questa parte?”, AI Mode riconoscerà l’oggetto e darà spiegazioni contestuali. Durante la presentazione, Google ha mostrato come Project Astra (un progetto di ricerca Google sull’AR) sia stato portato dentro AI Mode: Search diventa un partner che può vedere ciò che vedi tu, consentendo un botta-e-risposta sul mondo reale inquadrato dalla fotocamera. Immaginiamo di inquadrare una pianta e chiedere “che pianta è questa e come la curo?” – AI Mode identificherà la pianta (grazie al riconoscimento immagini di Lens) e fornirà consigli di giardinaggio specifici. Live Search rappresenta un primo passo verso la fusione di ricerca online e percezione del mondo reale, prefigurando casi d’uso futuri con occhiali AR.

Ricerche personalizzate

Grafici e analisi interattive

AI Mode è in grado anche di generare grafici su misura e analisi quantitative in risposta a certe query. Questa funzionalità si attiva quando la domanda dell’utente implica confronti numerici o dataset complessi. Google ha spiegato che AI Mode può analizzare set di dati complessi e creare grafici dinamici al volo, attingendo a dati aggiornati dal web. Ad esempio, se si chiede “confronta l’effetto campo di casa di due squadre di baseball differenti”, AI Mode elaborerà i dati statistici sulle vittorie in casa/fuori casa di quelle squadre e genererà un grafico interattivo che mostri le differenze Allo stesso modo, per domande finanziarie, potrebbe tracciare l’andamento di due titoli azionari. Questi grafici vengono costruiti usando le fonti attendibili di Google (es. dati sportivi in tempo reale, database finanziari), e consentono all’utente di visualizzare immediatamente le risposte invece di dover interpretare numeri in un articolo. È una sorta di integrazione di Google Data nei risultati di ricerca, con il potere narrativo dell’IA che spiega il grafico in parole semplici.

AI Mode genera grafici e analisi. Nell’immagine, alla query (ipotetica) di confronto tra due squadre di baseball, AI Mode produce un grafico interattivo a barre che mette in relazione le performance casalinghe. Sotto al grafico, l’IA fornisce anche un’analisi testuale (“il team A tende a vincere X% in casa…”) per guidare la lettura. Tutto questo avviene in tempo reale, utilizzando dati freschi dalle fonti Google e mostrando come la ricerca non si limiti più a link testuali ma includa elementi visivi esplicativi

Shopping AI e ricerca di prodotti con agent

Il settore shopping riceve un impulso notevole da AI Mode. Google ha integrato il suo vastissimo Shopping Graph (oltre 50 miliardi di prodotti, aggiornati di continuo) direttamente nelle risposte AI, creando un’esperienza d’acquisto guidata dall’intelligenza artificiale. In pratica, l’utente può fare domande generiche come “sto cercando una borsa da viaggio carina” e AI Mode inizierà a interagire per capire i gusti e i bisogni, mostrando anche prodotti pertinenti man mano. Ad esempio, nel keynote è stato mostrato che dicendo “una borsa per un viaggio a Portland in maggio”, AI Mode ha avviato un query fan-out shopping: ha effettuato ricerche parallele per capire cosa rende buona una borsa per la pioggia e i viaggi lunghi, poi ha usato quei criteri per filtrare e suggerire prodotti impermeabili con tasche capienti Il tutto presentato in un pannello visuale sulla destra con immagini di prodotti e schede dettagliate, aggiornato dinamicamente mentre la conversazione procede. L’utente può affinare i requisiti e vedere i suggerimenti aggiornarsi in tempo reale, scoprendo anche nuovi brand che corrispondono alle sue esigenze. Insomma, AI Mode diventa un personal shopper che capisce le preferenze espresse a parole e pesca dal grafo prodotti di Google quelli più adatti.

Ma non è finita qui: AI Mode introduce anche capacità agentiche nel processo di shopping. “Agentic” significa che l’IA non si limita a consigliare, ma può anche agire per conto dell’utente in determinati compiti. Ad esempio, se l’utente individua un prodotto interessante, può dire a Google di monitorarne il prezzo. Con un click su “track price”, AI Mode chiederà all’utente alcune preferenze (taglia, colore, budget massimo) e poi si occuperà di tenere d’occhio il prezzo e completare l’acquisto automaticamente al momento giusto. In concreto, Google memorizzerà il desiderio di acquisto e, se il prezzo scende sotto la soglia impostata, avviserà l’utente e potrà procedere a mettere il prodotto nel carrello del sito del venditore e avviare il checkout tramite Google Pay con un semplice tap di conferma dell’utente. Questa funzione, che ricorda un assistente personale per lo shopping, verrà implementata inizialmente per alcuni utenti US e per partner specifici.

Esperienza di Shopping agentico in AI Mode. L’immagine mostra la sequenza: l’utente traccia un articolo (ad es. un paio di scarpe) impostando prezzo desiderato e preferenze; quando il prezzo scende, AI Mode notifica e, su conferma, completa l’acquisto automaticamente compilando moduli e processando il pagamento (Google Pay). Google definisce questa funzione “agentica” perché l’AI svolge il lavoro operativo (monitoraggio e checkout) al posto dell’utente. L’utente rimane comunque “in controllo” – è lui a decidere cosa e dove acquistare – ma risparmia tempo delegando all’AI i passi noiosi. Funzionalità simili potrebbero in futuro estendersi ad altre azioni, come prenotazioni di ristoranti o appuntamenti.

Azioni automatizzate (Agentic Actions)

Generalizzando il concetto sopra, Google sta sperimentando un’integrazione di AI agent all’interno della ricerca per vari compiti. Hanno soprannominato questa iniziativa Project Mariner, e l’obiettivo è che l’AI possa eseguire task su richiesta dell’utente direttamente dai risultati di ricerca. Un esempio presentato è stato: “Trova 2 biglietti economici per la partita dei Reds di sabato prossimo nel settore inferiore dello stadio”. AI Mode, sentita questa richiesta, ha avviato dietro le quinte un query fan-out andando su vari siti di ticketing, ha analizzato centinaia di opzioni di biglietti in tempo reale (considerando i prezzi e la disponibilità) e ha compilato per l’utente un elenco di opzioni che rispondono ai criteri esatti (due posti vicini, nel livello inferiore, costo entro il budget. Dopodiché, l’utente può scegliere l’opzione preferita e completare l’acquisto, sempre restando nell’ambiente di AI Mode. Il sistema in questo caso ha persino gestito il filling dei moduli nei siti di terze parti. Google ha voluto sottolineare che, nonostante l’automazione, “l’utente è in controllo”: l’AI non spenderà soldi senza consenso, ma può semplificare enormemente procedure come trovare e prenotare biglietti, che normalmente richiederebbero tanti passaggi manuali.

Inizialmente queste azioni agentiche verranno implementate per scenari limitati (biglietti per eventi, prenotazioni ristoranti, appuntamenti locali) e con partner specifici (ad esempio Ticketmaster, StubHub, OpenTable/Resy, Vagaro). Resta aperta la questione di come potranno partecipare siti di terze parti più piccoli o indipendenti: se l’AI in futuro potrà interagire con qualsiasi sito (magari tramite API standard o protocolli) per eseguire azioni, oppure se rimarrà circoscritto a partnership commerciali. In ogni caso, la direzione è chiara: Google sta trasformando la ricerca da un sistema di recupero informazioni a un sistema di esecuzione di compiti, dove la frontiera tra cercare e fare si assottiglia.

Integrazione profonda con l’ecosistema Google

AI Mode sfrutta a piene mani i dati e i servizi interni di Google per arricchire le risposte. Oltre al già citato Shopping Graph, sono integrati: il Knowledge Graph (per rispondere a fatti enciclopedici consolidati), Google Maps e i dati locali (per fornire risposte geolocalizzate e schede di attività commerciali), Google Travel (voli, hotel), Google News (per attingere a news recenti), e altri ancora. Quando un utente fa una domanda, l’IA può intrecciare queste fonti senza soluzione di continuità. Ad esempio, chiedendo “migliore pizza di Milani”, AI Mode potrebbe fornire una lista ragionata di pizzerie, e ciascun nome potrebbe essere collegato tramite un’icona al profilo Google Maps di quel ristorante (anziché al sito web), mostrando recensioni, orari, etc. La nostra ricerca su Milano ad esempio ha evidenziato proprio questo: AI Mode, quando menziona aziende o luoghi, spesso inserisce collegamenti puntiformi “dotted” che aprono un pannello interno di Google (es. la scheda Google My Business) invece di portare al sito ufficiale.

Perfino se l’utente chiede esplicitamente il link al sito ufficiale, AI Mode potrebbe continuare a offrire il collegamento alla scheda Google da cui poi eventualmente navigare al sito, anziché un link diretto esterno. Ciò dimostra come l’obiettivo sia fornire tutte le informazioni possibili senza far uscire l’utente da Google. Certamente il link al sito esterno rimane disponibile (dalla scheda aziendale si può accedere al sito, e Google mantiene i parametri UTM se presenti, però è un passo in più che molti utenti potrebbero non compiere se l’informazione desiderata è già visibile nella risposta AI.

Questa integrazione multi-servizio consente ad AI Mode di rispondere in modo poliedrico: un’unica risposta può dirti un fatto, consigliarti un prodotto, mostrarti una mappa, e magari prenotarti un appuntamento – tutto insieme. Per Google è la realizzazione di un’esperienza utente estremamente coinvolgente e autosufficiente, dove la ricerca non è più un elenco di destinazioni ma la destinazione stessa.

Implicazioni SEO e consigli strategici

L’avvento di Google AI Mode rappresenta un cambio di paradigma per chi si occupa di SEO e content marketing. Di seguito analizziamo le principali implicazioni e come prepararsi a questa nuova era della ricerca.

1. Visibilità organica e traffico: verso lo zero-click

Con AI Mode, Google fornisce risposte esaustive direttamente sulla sua piattaforma, il che riduce la necessità per l’utente di cliccare su siti esterni. In molti casi, l’utente potrebbe trovare soddisfazione nella risposta generata dall’IA senza visitare alcun sito web tradizionale. Questo fenomeno, già iniziato con i featured snippet e i pannelli informativi, esplode in AI Mode: si parla di comportamento zero-click portato all’estremo. Dal punto di vista dei siti web, ciò si traduce in un potenziale calo di traffico organico, anche per quei contenuti che vengono effettivamente utilizzati dall’IA per formulare la risposta. Infatti, AI Mode potrebbe attingere alle informazioni di un sito e presentarle all’utente senza generare una visita (a meno che l’utente non espanda le citazioni e scelga di cliccare).

Un problema aggiuntivo per i SEO è che questo traffico “mediato dall’AI” risulta difficilmente tracciabile. Attualmente, Google ha dichiarato che in Search Console i dati di AI Mode non verranno separati nei rapporti di performance. Le impressioni e i clic generati all’interno di AI Mode confluiranno nei dati generali del sito come parte della Ricerca Google, senza la possibilità di distinguere se un clic proviene dal risultato classico o da AI Mode. Inoltre, sembra che i clic generati dall’interno di AI Mode non passino il referrer “google.” tradizionale, rendendoli invisibili anche su Google Analytics/GA4 (un po’ come accadde con il “not provided”). In altre parole, se un utente clicca un link in AI Mode, quel traffico potrebbe apparire come direct o proveniente da Google Maps, etc., ma non come “Google Search > AI Mode”. Ciò complica la vita ai marketer, che faticano a quantificare quante visite stanno arrivando effettivamente grazie alla presenza nei risultati AI.

Google dal canto suo suggerisce un cambio di prospettiva: in recenti comunicati ha enfatizzato che, sebbene i clic possano diminuire, la qualità delle visite provenienti dalla ricerca (AI) è superiore, perché l’utente che clicca dopo una risposta AI è altamente motivato e ha già contesto. Inoltre, Google consiglia di non misurare più il successo solo in termini di click ma di considerare metriche di coinvolgimento e soddisfazione utente. In pratica, sta preparando i publisher all’idea che meno traffico organico non significhi per forza meno valore, se quell’organico è ultra-qualificato. Resta il fatto che per molti siti web il traffico è fondamentale (es. testate che monetizzano con adv) e il timore è di trovarsi con contenuti “saccheggiati” dall’AI senza riceverne visita.

Cosa fare: in questo scenario, diventa importante ottenere la citazione nella risposta AI (quando possibile) e costruire una forte brand presence. Se l’AI menziona il nostro sito o lo usa come riferimento, assicurarsi di avere il nome del sito ben visibile (es. nell’URL o nel brand mention) può aumentare la chance che l’utente riconosca la fonte e visiti direttamente quel sito per approfondire. Inoltre, puntare su contenuti che invoglino all’azione o alla visita – per esempio strumenti interattivi, community, offerte esclusive – può dare un motivo in più all’utente di cliccare oltre la risposta AI.

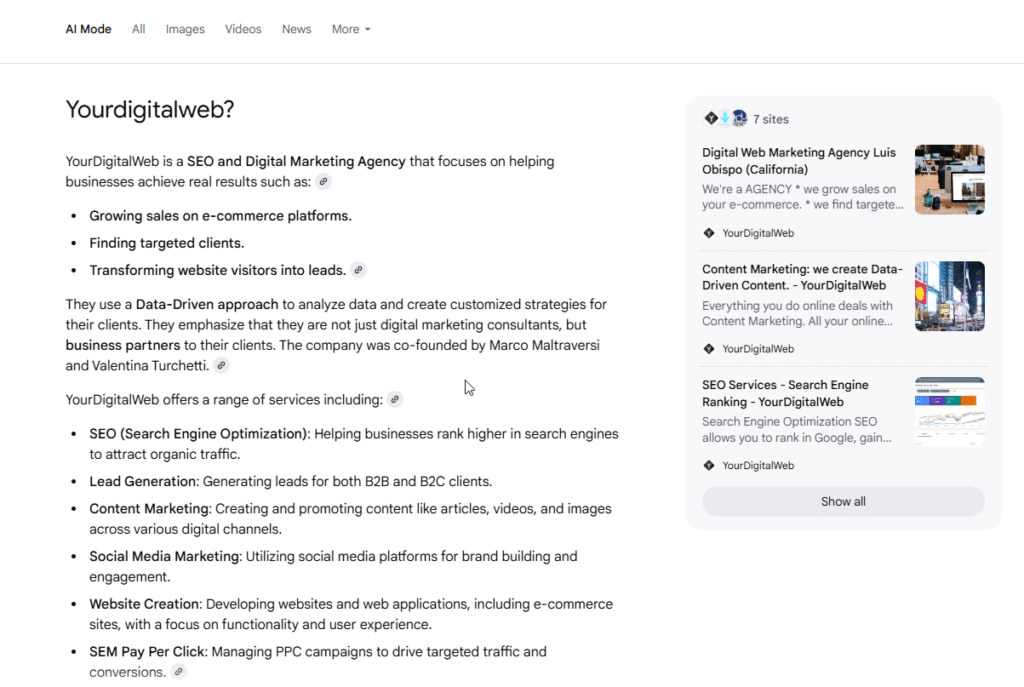

In Yourdigitalweb aiutiamo le aziende a migliorare la visibilità AI costruendo citazioni e fonti per essere visibili. Lavoriamo ogni giorno con l’AI e studiamo metodologie per supportare questa evoluzione!

2. Ranking dinamico e fine del “posizionamento” statico

Come illustrato, AI Mode rivoluziona il concetto di ranking: non esiste più una Top 10 fissa uguale per tutti, ma un ranking dinamico e multidimensionale. Il nostro contenuto potrebbe essere usato dall’AI come parte di una risposta anche se non era #1 per la query originale, purché allinei semantica e contestualmente uno dei sotto-temi rilevanti. Viceversa, potremmo essere primi per la query principale in modalità classica, ma se il nostro contenuto non risponde a nessuno dei sub-quesiti che l’AI esplora, potremmo essere completamente esclusi dalla risposta AI. Mike King di iPullRank evidenzia proprio che “posizionarsi #1 per la query principale non garantisce visibilità in AI Mode”, perché l’AI seleziona i passaggi in base all’allineamento con le query nascoste del fan-out, rendendo la comparsa in AI Mode un “evento matriciale complesso”

Inoltre, la personalizzazione spinta implica che non esiste un risultato universale: potremmo essere inclusi nella risposta AI per un utente (magari perché il nostro contenuto combacia esattamente con un suo interesse storico), ma non comparire per un altro utente con query uguale. Il ranking diventa probabilistico, non deterministico. Ciò sfida tutti i modelli mentali del SEO tradizionale, che finora si basava su analisi di SERP medie e monitoraggio di posizioni standard.

Cosa fare: i SEO dovranno adattare i propri strumenti e approcci. Una strategia potrebbe essere monitorare la presenza del proprio contenuto nelle risposte AI attraverso profili utente simulati. Ad esempio, creare diversi account Google con cronologie differenti (profilo tech, profilo newbie, profilo localizzato) e osservare come appare AI Mode per query target, per capire se e quando il proprio sito viene citato. Inoltre, bisognerà concentrarsi non solo sul ranking per la query secca, ma sul catturare query correlate e di contesto. Un concetto che emerge è quello di “synthetic query landscape”: immaginare quali sotto-domande l’AI potrebbe generare attorno a una query e assicurarsi di avere contenuti che le coprano. Ad esempio, per “miglior SUV elettrico”, le query latenti potrebbero essere “autonomia più lunga”, “sicurezza famiglie”, “prezzo economico” – un sito di automotive che voglia emergere dovrebbe trattare tutti questi aspetti nei suoi contenuti.

3. Contenuti ottimizzati per l’AI: focus su passaggi e completezza

Nell’era AI Mode, ottimizzare significa andare oltre la pagina nel suo complesso e curare il contenuto a livello di singolo passaggio. Come abbiamo visto, i modelli LLM confronteranno paragrafi specifici tra siti diversi e sceglieranno quello più chiaro, completo e rilevante per ciascun sotto-tema. Ciò implica che ogni paragrafo del nostro articolo deve poter “reggere” un confronto diretto con i paragrafi degli articoli concorrenti. Se nel nostro articolo ci sono parti lacunose, frasi ambigue o informazioni meno precise, potremmo perdere quel confronto anche se il resto della pagina è ottimo. Elementi come la chiarezza, la completezza e la specificità dei passaggi diventano cruciali. Ad esempio, se scriviamo una guida “10 consigli per risparmiare energia”, e un altro sito ne ha una simile ma ogni consiglio sul loro è spiegato con un dato concreto mentre il nostro è generico, l’AI probabilmente preferirà i passaggi dell’altro sito.

Inoltre, l’AI è molto sensibile alla semantica: usare termini precisi e mantenere un buon “embedding alignment” (allineamento vettoriale) con l’argomento è fondamentale. Contenuti fuorvianti o “gonfiati” con parole chiave ripetute non serviranno – anzi, un LLM avanzato potrebbe penalizzare testo ridondante o poco informativo.

Cosa fare: per prime, migliorare la qualità intrinseca dei contenuti. Questo significa:

- Strutturare gli articoli in modo da coprire in modo approfondito ogni sotto-argomento pertinente (potremmo usare tecniche di content gap analysis per individuare quali domande correlate aggiungere).

- Curare ogni paragrafo come un’entità quasi indipendente: dovrebbe avere un’idea chiave chiara e supportata da dettagli o esempi. In altre parole, puntare a creare molti “passaggi vincenti” all’interno del proprio contenuto

- Evitare fuffa e riempitivi; preferire frasi dirette e informazioni verificabili. Ricordiamo che un modello AI farà confronto qualitativo, non quantitativo: “quale di questi due testi risponde meglio?”. Quindi il contenuto deve eccellere qualitativamente, non solo essere presente.

- Utilizzare schema e dati strutturati dove possibile: ciò può aiutare l’AI a estrarre più facilmente informazioni accurate. Ad esempio, tabelle ben formattate con specifiche di prodotto, markup schema FAQ per domande/risposte, ecc., potrebbero essere letti e incorporati nelle risposte AI con maggiore fedeltà.

- Incorporare prospettive uniche, esperienze dirette (E-E-A-T). Se forniamo esperienza di prima mano o analisi originali, diventiamo fonte autorevole e differenziata, aumentando le chance che l’AI attinga da noi. Viceversa, contenuti commodity (che ripetono cose trovabili ovunque) avranno meno probabilità di emergere.

In sintesi, i SEO dovranno abbracciare un approccio da “ingegneri della pertinenza” (“Relevance Engineers” come li chiama Mike King). Non basta più SEO superficiale; serve comprendere a fondo l’intento utente, i dati e come un’AI li elaborerebbe, e poi strutturare i contenuti di conseguenza.

- 4. Importanza del brand e dell’engagement dell’utente

Con la personalizzazione estrema, il comportamento dell’utente e la sua familiarità col brand diventano fattori indiretti di successo. Abbiamo visto che Google costruisce un embedding utente basato su click e preferenze passate. Ciò significa che se riusciamo, tramite altre vie, a far sì che un utente interagisca e apprezzi il nostro brand (ad esempio tramite social, newsletter, visite dirette), quell’utente avrà più probabilità di vedere i nostri contenuti emergere anche nelle sue future ricerche AI Mode (perché l’embedding utente includerà segnali positivi verso di noi Anche Google ha mostrato come la coerenza cross-piattaforma esista: stessi risultati su AI Mode e Gemini assistant quando l’utente è lo stesso. Dunque, costruire fedeltà e riconoscimento di marca può letteralmente influenzare le risposte AI personalizzate.

Cosa fare: investire in attività di brand marketing e community. Ciò può voler dire creare contenuti di grande valore che ottengano condivisioni e traffico anche fuori da Google (per es. su social o referral), aumentare la reputazione del sito (menzioni su testate autorevoli, backlink di qualità), e in generale far sì che gli utenti cerchino direttamente il nostro brand o si ingaggino con esso. Mike King suggerisce di influenzare il comportamento di ricerca degli utenti attraverso altri canali di branding. Un esempio pratico: se abbiamo un prodotto o servizio, spingere campagne che portino l’utente a cercare il nome del nostro brand insieme a parole chiave (invece di keyword generiche) – così Google capirà che per quell’utente il nostro brand è rilevante nel settore. In un certo senso, diventa cruciale essere nella mente dell’utente affinché l’AI di Google ci peschi nella sua memoria collegata all’utente.

5. Rethinking delle metriche e del workflow SEO

Infine, la comparsa di AI Mode costringerà a ripensare alcune metriche di performance e flussi di lavoro SEO:

-

-

Le impression in Search Console potrebbero aumentare enormemente (poiché ogni Deep Search o query fan-out fa comparire il sito in più query) ma senza un corrispettivo in clic. Dobbiamo capire come valutare l’impatto “invisibile” di essere citati senza clic. Forse nuove metriche emergeranno, come “presenza nelle risposte AI” o simili.

-

Gli A/B test SEO classici (modifico title e vedo come cambia CTR) diventano ardui, perché il CTR è diluito e condizionato dall’AI. Potrebbe essere più sensato testare variazioni di contenuto misurando se il tasso di citazione nelle risposte AI cambia – ma al momento non abbiamo strumenti diretti per questo. Si aprirà spazio per nuovi tool SEO dedicati al monitoraggio delle risposte AI (un po’ come oggi ci sono tool per trackare i featured snippet).

-

Collaborazione col team content: ancora più centrale. I SEO dovranno lavorare a stretto contatto con content strategist e editor per educarli a scrivere in ottica “AI-friendly” (ma sempre user-first). Ad esempio, insegnare a includere risposte dirette alle domande all’interno del testo, usare heading mirati alle possibili sotto-domande, ecc., in modo che l’AI possa trovare facilmente i chunk corrispondenti.

-

Tecniche black-hat o manipolative probabilmente perderanno efficacia. Non si potrà “ingannare” un LLM con keyword stuffing o link scheme – anzi, il rischio è di addestrare negativamente il modello verso il proprio sito se vengono rilevate pratiche scorrette. Quindi l’attenzione dovrebbe spostarsi ancora di più sulla qualità autentica.

-

La Modalità AI di Google Search segna l’inizio di una nuova era per i motori di ricerca, in cui le frontiere tra ricerca, assistenza e azione si fondono. Per gli utenti, questo significa ottenere informazioni più ricche, contestuali e immediate – il tutto con minore sforzo e in maniera sempre più personalizzata. Per i professionisti SEO e i creatori di contenuti, significa affrontare sfide inedite: dalla perdita di visibilità tradizionale all’esigenza di adattare i contenuti per essere compresi e valorizzati da un’intelligenza artificiale.

Come YourDigitalWeb può aiutare la tua azienda?

-

La ricerca sta cambiando. Google introduce risposte costruite dall’intelligenza artificiale, analizza i contenuti in modo più profondo, seleziona passaggi specifici, e personalizza tutto per l’utente. Ma non è solo questione di AI. È questione di comunicare meglio.

Da una parte serve struttura, chiarezza e affidabilità per i nuovi modelli AI. Dall’altra, serve essere utili, leggibili e rilevanti per chi legge davvero.

YourDigitalWeb lavora su entrambi i fronti. Non perché va di moda parlare di AI, ma perché oggi è l’unico modo serio per costruire visibilità online.

-

Ottimizziamo contenuti e siti per essere selezionati dalle risposte AI, ma anche per guidare l’utente reale: da una domanda a una scelta.

-

Studiamo cosa legge davvero il motore: non ci limitiamo alla classica SEO on-page, analizziamo come Google segmenta e usa i contenuti.

-

Aiutiamo i clienti a strutturare testi, dati e formati che funzionano sia per i modelli neurali sia per le persone che cercano chiarezza, affidabilità e orientamento.

Lavoriamo con aziende che vogliono costruire contenuti solidi, tecnicamente curati ma con un tono umano. Che vogliono essere trovate per ciò che sanno, non solo per come si ottimizzano.

Non ti promettiamo magie. Ti offriamo un approccio serio, trasparente, che unisce competenze SEO avanzate e attenzione alla comunicazione. Perché oggi, per farsi scegliere, non basta esserci: serve farsi capire.

Se vuoi portare la tua presenza online al livello successivo, ti ascoltiamo volentieri. E ti aiutiamo a farlo bene.

-

- Fonti e contributi:

Le informazioni contenute in questo articolo si basano su dichiarazioni ufficiali di Google (tra cui documentazione tecnica, comunicati e dimostrazioni durante Google I/O 2025), analisi dettagliate condotte da Mike King di iPullRank, osservazioni e test effettuati da esperti SEO come Lily Ray, oltre test effettuati sul campo. Sono stati condotti test da Yourdigitalweb per testare AI Mode e supportare le informazioni e i dettagli